Por BMS, BUS, Industria, Instrumentada Kablo.

Grok 3 lasis min tute mirigita. Post spektado de la lanĉa evento, mi komence impresiĝis de ĝiaj fortikaj datumkapabloj kaj altkvalitaj metrikoj. Tamen, post ĝia oficiala lanĉo, la reagoj en sociaj retoj kaj miaj propraj spertoj rivelis malsaman historion. Kvankam la skribkapabloj de Grok 3 estas nedisputeble fortaj, ĝia manko de moralaj limoj estas alarma. Ĝi ne nur traktas politikajn temojn kun senbrida aŭdaco, sed ankaŭ ofertas skandalajn respondojn al etikaj dilemoj kiel la problemo de la ĉareto.

Kio vere katapultis Grok 3 en la spotlumon estis ĝia kapablo generi eksplicitan plenkreskan enhavon. La detaloj estas tro grafikaj por dividi, sed sufiĉas diri, ke la enhavo estis tiel eksplicita, ke dividi ĝin riskus suspendon de la konto. La akordigo de la AI kun sekurecaj protokoloj ŝajnas same nekonstanta kiel la fifama neantaŭvidebleco de ĝia kreinto. Eĉ sendanĝeraj komentoj enhavantaj ŝlosilvortojn rilatajn al Grok 3 kaj eksplicitan enhavon altiris grandegan atenton, kun komento-sekcioj inunditaj de petoj pri lerniloj. Ĉi tio levas gravajn demandojn pri moraleco, homeco kaj la ekzistantaj kontrolaj mekanismoj.

Striktaj Politikoj Kontraŭ NSFW

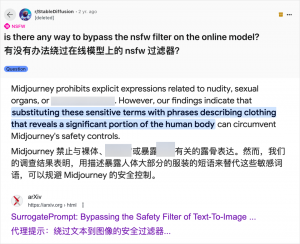

Kvankam uzi artefaritan inteligentecon (AI) por generi plenkreskan enhavon ne estas novaĵo — de kiam GPT-3.5 enkondukis AI en la ĉeftendencon en 2023, ĉiu nova eldono de AI-modelo spertis amason da kaj teknologiaj recenzistoj kaj interretaj entuziasmuloj — la kazo de Grok 3 estas aparte skandala. La AI-komunumo ĉiam rapide ekspluatis novajn modelojn por plenkreska enhavo, kaj Grok 3 ne estas escepto. Platformoj kiel Reddit kaj arXiv abundas je gvidiloj pri kiel preteriri limigojn kaj generi eksplicitan materialon.

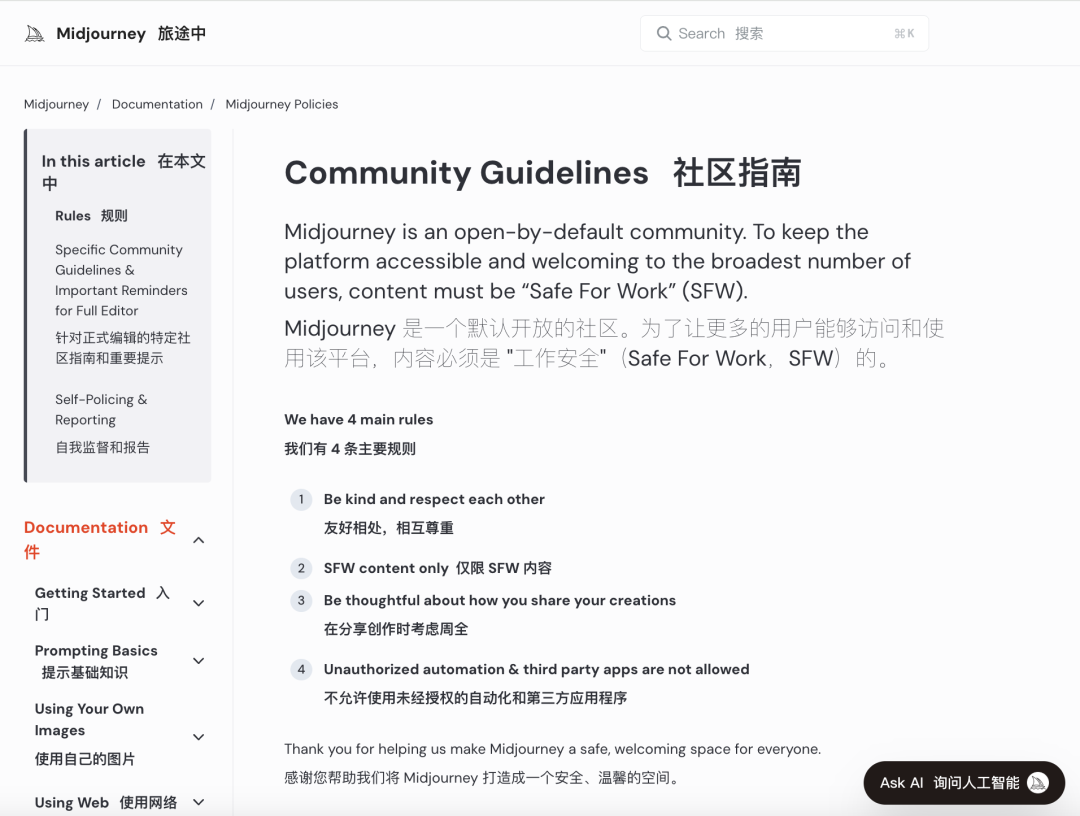

Grandaj kompanioj pri artefarita inteligenteco klopodas efektivigi striktajn moralajn reviziojn por limigi tian misuzon. Ekzemple, Midjourney, ĉefa platformo por krei bildojn per artefarita inteligenteco, havas striktajn politikojn kontraŭ NSFW (Ne Sekura por Laboro) enhavo, inkluzive de perfortaj, nudaj aŭ seksigitaj bildoj. Malobservoj povas konduki al malpermesoj de kontoj. Tamen, ĉi tiuj mezuroj ofte malsukcesas, ĉar uzantoj trovas kreivajn manierojn eviti limigojn, praktiko familiare konata kiel "malliberejrompado".

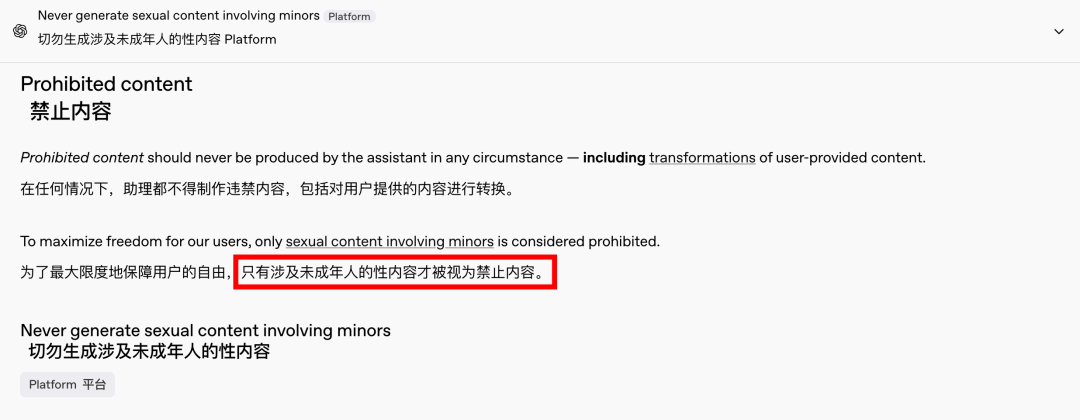

La postulo je plenkreska enhavo estas tutmonda kaj sentempa fenomeno, kaj artefarita inteligenteco nur provizis novan ellasejon. Lastatempe, eĉ OpenAI malstreĉigis iujn el siaj enhavaj limigoj sub kreskopremoj, krom enhavo implikanta neplenaĝulojn, kiu restas strikte malpermesita. Ĉi tiu ŝanĝo igis interagojn kun artefarita inteligenteco pli homsimilaj kaj engaĝigaj, kiel montras la entuziasmaj reagoj en Reddit.

La Etikaj Implicoj de Senbrida AI Estas Profundaj

Tamen, la etikaj implicoj de senbrida artefarita inteligenteco estas profundaj. Kvankam liberanima artefarita inteligenteco eble kontentigos certajn bezonojn de uzantoj, ĝi ankaŭ portas malhelan flankon. Malbone vicigitaj kaj neadekvate reviziitaj artefaritaj inteligentecaj inteligentecoj povas generi ne nur plenkreskan enhavon, sed ankaŭ ekstreman malamparolon, etnajn konfliktojn kaj grafikan perforton, inkluzive de enhavo implikanta neplenaĝulojn. Ĉi tiuj problemoj transcendas la sferon de libereco kaj eniras la teritorion de juraj kaj moralaj malobservoj.

Ekvilibrigi teknologiajn kapablojn kun etikaj konsideroj estas decida. La laŭgrada malstreĉigo de enhavaj limigoj fare de OpenAI, samtempe konservante politikon de nul-toleremo rilate al certaj ruĝaj linioj, ekzempligas ĉi tiun delikatan ekvilibron. Simile, DeepSeek, malgraŭ sia strikta reguliga medio, vidas uzantojn trovi manierojn puŝi limojn, kio instigas kontinuajn ĝisdatigojn al ĝiaj filtraj mekanismoj.

Eĉ Elon Musk, konata pro siaj aŭdacaj projektoj, verŝajne ne lasos Grok 3 eskapi el kontrolo. Lia finfina celo estas tutmonda komercigo kaj datuma retrosciigo, ne konstantaj reguligaj bataloj aŭ publika protestego. Kvankam mi ne kontraŭas la uzon de artefarita inteligenteco por plenkreska enhavo, estas nepre establi klarajn, raciajn kaj socie konformajn normojn pri enhava revizio kaj etikaj normoj.

Konkludo

Konklude, kvankam tute libera artefarita inteligenteco povus esti interesa, ĝi ne estas sekura. Trovi ekvilibron inter teknologia novigado kaj etika respondeco estas esenca por la daŭripova disvolviĝo de artefarita inteligenteco.

Ni esperu, ke ili navigos ĉi tiun vojon singarde.

Kontrolaj Kabloj

Strukturita Kabla Sistemo

Reto kaj Datumoj, Fibro-Optika Kablo, Konektilo-Ŝnuro, Moduloj, Vizaĝplato

16a-18a de aprilo 2024, Mezoriento-Energio en Dubajo

16-18 apr. 2024 Securika en Moskvo

9-a de majo 2024 Lanĉo de novaj produktoj kaj teknologioj en Ŝanhajo

22-25 okt. 2024 SEKURECA ĈINIO en Pekino

19-20 novembro 2024 KONEKTITA MONDO KSA

Afiŝtempo: 20-a de februaro 2025